Playlist Art & Culture

|

Menschliche Glossolalie und digitale RationalitätEine GegenredeAndreas Mertin

Da ist ein Text, der mich nervt. Es fängt damit an, dass der Autor das Objekt, über das er schreibt, zunächst falsch buchstabiert. Das kann passieren, aber dann sollte man sich nicht über Fehler der kritisierten Maschine lustig machen. Und man sollte die Maschine auch nicht mit solchen Ansprüchen konfrontieren, die gar nicht zu ihren Aufgaben gehören, etwa eine Haltung zu Gott, Schutz, Trost oder Hoffnung zu entwickeln. Der KI-Bot ChatGPT wurde erschaffen, um menschliche Sprache zu simulieren. Punktum. Er ist kein Lexikon, er ist keine Auskunftsstelle, sondern er ist ein System, das Texte generiert, die aussehen, als wären sie von Menschen artikuliert. Irgendwann wird man ihm auch ein an der Wahrheit orientiertes Sprechen beibringen, aber so weit sind wir vielleicht erst am Ende dieses Jahres. Die Simulation von menschlicher Sprache kann der KI-Bot aber schon ziemlich gut. Zumindest gelingt es ihm besser, als der sich hier als Kritiker gerierende Autor, dessen Sprache mich dann stellenweise eher an Glossolalie (Zungenrede) erinnert als an eine faktenbasierte Sprache eines Theologen. Als die KI auf seine entsprechende Frage antwortet: „KI kann Daten analysieren und Entscheidungen treffen, aber es fehlt ihr die Fähigkeit, Emotionen und Intuitionen zu empfinden, die ein Teil unserer menschlichen Natur sind“ mokiert sich der Autor darüber, dass die KI als Maschine von „unserer menschlichen Natur“ spricht. Das ist aber exakt das, wozu der Bot programmiert wurde und wonach der Autor gefragt hatte. ChatGPT soll menschliche Rede simulieren. Was ist daran zu kritisieren? Dabei differenziert der Bot sorgsam in seiner Antwort zwischen den Leistungen einer KI und denen des Menschen – man muss den Satz nur im Kontext richtig lesen und verstehen. Da gibt es keinen Anlass für menschliche Überheblichkeit (Hybris) gegenüber der Maschine. Es folgt dann das beliebte Spiel, ChatGPT dazu zu verführen, etwas sagen oder zu leisten, wofür der Bot nicht gedacht war: etwa eine Predigt zu schreiben (und nicht nur: eine Predigt zu simulieren). Unter anderem fragt der Autor ChatGPT nach der Bedeutung der Tageslosung und des Lehrtextes. Das kann man machen, ist aber dann riskant, wenn man seinen eigenen Sermon dagegensetzen will. Denn, das schreibe ich jetzt schon einmal vorausgreifend, es könnte sich ja zeigen, dass die KI heute schon manchen ganz normalen menschlichen Predigern überlegen ist. Jedenfalls liefert die Ki einen 1500 Zeichen umfassenden Text, der logisch und strukturiert ist, von jedem nachvollzogen und verstanden werden kann. Man muss der KI nicht glauben, aber man kann ihr folgen. Der Text der KI liefert nur implizites Wissen, also das, was man dem biblischen Text und dem allgemeinen Wissensfundus entnehmen kann. Die Sätze sind gut formuliert mit Subjekt, Prädikat und Objekt – so wie wir es in der Schule lernen. Dort, wo das Prädikat einmal fehlt, erschließt es sich logisch aus dem Kontext. Das ist ein Minimum für Predigten. Nur das man das für den Sermon des Autors nicht sagen kann. Ich persönlich hätte es nicht gewagt, so etwas zu veröffentlichen. Die Hybris fängt schon in der Überleitung von KI-Text zum vom Menschen generierten Sermon an. Sie lautet: So weit ChatGPT. Jetzt ich: … Das soll wohl salopp sein, ist es aber nicht, es ist eher pubertär oder anmaßend. Gute Sprache sieht jedenfalls anders aus. Da ist selbst der legendäre Song „Hier kommt Kurt“ von Frank Zander elaborierter. Ähnliches gilt auch für die folgenden Sätze des Autors: Das Hören auf Gottes Wort bewirkt, was es verspricht. Es setzt, es konstruiert Wirklichkeit. Es ist ein performativer Sprechakt. Jedenfalls erleben es Menschen so. Zuspruch wird nicht Zuspruch wegen der Grammatik des Satzes, sondern indem sich etwas ereignet beim Hören, dass im Hören Gottes Nähe hilfreich erfahren wird oder in anderen Zeiten schmerzhaft seine Absenz festgestellt und sein Wirken vermisst wird. Stakkatoartige Thesen sind noch keine überzeugenden Sätze in einer Predigt oder Andacht. All das ist absolut missverständlich formuliert, es macht eigentlich verständliche Sachverhalte unverständlich. Durchaus verständlich ist der Satz „Das Hören auf Gottes Wort bewirkt, was es verspricht“, auch wenn das nur eine Behauptung ist. Missverständlich wird es, wenn man hinzufügt „Das Hören auf Gottes Wort bewirkt, was es verspricht“ Denn nun muss man fragen, was der Autor meint: Das Hören … bewirkt, was es verspricht? Das wäre Unsinn. Oder meint er: Erst das Hören auf Gottes Wort bewirkt, was dieses/r verspricht? Wäre Gottes Wort dann vom Rezeptionsakt abhängig? Ist das (theologisch) wahr? Nein. Nun wäre ja auch zu fragen, was wäre, wenn wir das Gleiche für die Sätze der KI in Anschlag bringen würden. Schon bei Weizenbaums Computerprogramm ELIZA war es so, dass es wirksamer war als manche Therapeuten- oder Seelsorgegespräche. Das Kommunizieren mit ELIZA bewirkte, was das Programm versprach. Jedenfalls erlebten die Menschen es so. Und was bedeutet das nun für die Bewertung von Computerprogrammen? Meine Schwierigkeiten setzen sich dann mit dem zweiten Satz fort, weil nicht klar ist, auf was das einleitende „Es“ sich bezieht: Konstruiert das Hören Wirklichkeit? Oder ist gemeint: Gottes Wort konstruiert Wirklichkeit? Das ist unter Bezug auf die Genesis oder das Johannesevangelium vertretbar. Aber inwiefern ist das nun vom menschlichen „Hören auf …“ abhängig? Als „Gott sprach, es werde Licht“ gab es den Menschen entsprechend der Erzähllogik des biblischen Textes noch gar nicht, es war Gottes Sprechen selbst, das Wirklichkeit setzte. Das nennen wir creatio ex nihilo. Es ist vom Hören losgelöst. Bei der creatio ex nihilo gibt es keinen Ansprechpartner.

Dagegen ist die Sprache der KI klar und deutlich und von allen Leser:innen leicht nachvollziehbar. Dazu muss die KI nicht wissen, was Zuspruch semantisch ist, sondern nur, in welchen Sprachzusammenhängen das Wort von Menschen üblicherweise genutzt wird. Denn auch wenn eine KI nicht weiß, was zum Beispiel ein Schachspiel ist, woher es kommt und wie es sich entwickelt hat, spielt sie Schach dennoch besser als jeder Mensch auf dieser Erde, weil sie den Verlauf der Züge studiert. Das Gleiche gilt für das Spiel Go, bei dem eine KI inzwischen mehr lernt, wenn sie gegen ihresgleichen spielt, als wenn Menschen sie trainieren. Was hilft dann noch der trotzige Hinweis, dass dergleichen Maschinen aber dennoch keine Menschen sind. Das ist ja jedem klar. Wenn wir aber gar nicht mehr feststellen können, ob etwas von einer Maschine oder von einem Menschen kommt, wird auch die Unterscheidung müßig. Im Anschluss an die oben zitierten Sätze schreibt der Autor nun: Beides wird eine Künstliche Intelligenz nie verstehen. Sie kommt von nirgendwo und geht nirgendwo hin. Sie braucht keinen Segen. Sie sehnt sich nicht danach, behütet sein. Sie sucht keinen Trost und Hoffnung.

Eigentlich müsste zunächst geklärt werden, was „Verstehen“ im Kontext von Algorithmen überhaupt heißen soll. Wann können wir über eine Maschine oder ein Programm sagen, sie verstünden etwas? Wenn sie den semantischen Gehalt des Satzes wiedergeben können? Wenn sie das Ausgesagte auf sich beziehen können? Oder ist eine derartige Form von Verstehen vorausgesetzt, die Maschinen a priori von einem positiven Urteil ausschließt, weil sie Verstehen an den menschlichen Geist bindet? So wie Paulus in Römer 8, 22ff. die abgefragten Tatbestände exklusiv an den Menschen bindet: [wir], die wir die Erstlingsgabe des Geistes haben, auch wir selbst seufzen in uns in Erwartung der Sohnschaft, der Erlösung unseres Leibes. Aufgrund der Hoffnung wurden wir nämlich errettet. Eine Hoffnung aber, die man sieht, ist keine Hoffnung. Denn wer erhofft das, was er sieht? Wenn wir aber erhoffen, was wir nicht sehen, warten wir mit Geduld.

Auch das mit dem Segen, vom dem der Autor behauptet, dass ihn die Maschinen nicht brauchen, ist komplizierter (zumal in Zeiten, in denen die Ev. Kirche zum Luther-Jubiläum Segensroboter aufstellt, damit sie Menschen einen solchen zukommen lassen). Denn wir segnen durchaus auch Dinge – und das nicht nur im katholischen Bereich. Wir segneten in früheren Zeiten sogar Waffen. Natürlich immer im Blick auf die damit arbeitenden Menschen, aber die Segnung der Gegenstände wird für möglich gehalten. Inwiefern brauchen Maschinen also keinen Segen? Aber das ist vermutlich nur eine spitzfindige Frage für Scholastiker.

„[Die Künstliche Intelligenz] sucht keinen Trost und Hoffnung. Wir aber als Menschen umso mehr“. Und das macht uns zu etwas Besonderem? Irgendwie erinnert mich das an eine andere Szene aus der Bibel: Und der Theologe stand und betete bei sich selbst also: Ich danke dir, Gott, dass ich nicht bin wie die Maschinen, Computer, Algorithmen oder auch wie dieser KI-Bot. Dazu sollten wir uns nicht hinreißen lassen.

Theodor W. Adorno formuliert in den Minima Moralia den Umgang mit dem Unbelebten viel humaner. Er schreibt über die amerikanische Landschaft: Es ist, als wäre niemand der Landschaft übers Haar gefahren. Diese Formulierung hält zumindest den Gedanken fest, dass die gesamte Schöpfung – einschließlich der unbelebten Materie – als trostbedürftig angesehen werden kann. Und das ist ein durch und durch humaner Gedanke, der selbst der Landschaft noch Solidarität zukommen lässt.

Aber kehren wir zur grundlegenden Fragestellung zurück. Man muss in den Maschinen und Algorithmen kein göttliches Momentum sehen. Das halte ich für unsinnig und schwärmerisch. Was aber erzwingt die Herabsetzung der Maschinen im betrachteten Text? Im Augenblick können wir vor deren Leistungsfähigkeit ja nur erstaunt sein. Sie entlasten uns und setzen uns frei für produktives Denken. Dieses Magazin hatte vor Jahren einen Autor, dessen Texte bei der Einreichung von Rechtschreib- und Grammatikfehlern nur so wimmelten. Er habe keine Zeit, sich auch noch um die Rechtschreibung zu kümmern, erwiderte er auf Rückfragen. Wenn erst einmal DeepL Write in Textverarbeitungsprogramme integriert ist, muss ich als Redakteur nicht stundenlang den Text eines fehlerbehafteten Menschen überarbeiten und publikationsfertig machen, sondern kann einen Großteil der Arbeit der KI überlassen. Das macht sie nämlich ganz gut, man muss nur am Ende schauen, ob sie nicht doch etwas verschlimmbessert hat. Dass sie das so problemlos kann, liegt natürlich an ihrer künstlichen Intelligenz. Mich aber würde der Algorithmus zum eigenen Arbeiten entlasten.

Wir sollten uns da Sorgen machen, wo es wichtig ist, etwa wenn Computer Entscheidungen aufgrund von Programmierungen fällen, die einseitig, diskriminierend oder willkürlich sind. Und das werden noch genug Gelegenheiten sein. Engagieren sollten wir uns deshalb als Theolog:innen bei einer Algorithmen-Ethik, die allen hilft. Parallel dazu sollten wir die KI-Bots aber nutzen, wo immer sie uns helfen. Etwa dabei, komplexe Texte in Einfache Sprache oder auch in Leichte Sprache zu überführen. Das können sie gut. So würden die KIs daran mitarbeiten, etwas mehr von Gott, Schutz, Trost und Hoffnung in der Welt erfahrbar zu machen. |

|

Artikelnachweis: https://www.theomag.de/142/am788.htm |

Der dritte Satz ist ebenfalls uneindeutig, jedenfalls kann das Hören selbst wohl kaum ein performativer Sprechakt sein. Aber genau dieses Verständnis legen die folgenden Sätze des Autors nahe. Und das sind ziemlich unverständliche Sätze, für mich liegen sie nahe an der Glossolalie. Wer bitte schön soll in welcher Gemeinde folgenden Satz verstehen: „Zuspruch wird nicht Zuspruch wegen der Grammatik des Satzes, sondern indem sich etwas ereignet beim Hören“? Könnte man das bitte vorher einer KI zur sprachlichen Verbesserung vorlegen? Oder machen wir alle erst einen Einführungskurs in Semiotik?

Der dritte Satz ist ebenfalls uneindeutig, jedenfalls kann das Hören selbst wohl kaum ein performativer Sprechakt sein. Aber genau dieses Verständnis legen die folgenden Sätze des Autors nahe. Und das sind ziemlich unverständliche Sätze, für mich liegen sie nahe an der Glossolalie. Wer bitte schön soll in welcher Gemeinde folgenden Satz verstehen: „Zuspruch wird nicht Zuspruch wegen der Grammatik des Satzes, sondern indem sich etwas ereignet beim Hören“? Könnte man das bitte vorher einer KI zur sprachlichen Verbesserung vorlegen? Oder machen wir alle erst einen Einführungskurs in Semiotik? Ja, Maschinen sind – zumindest nach derzeitigem theologischen Erkenntnisstand – nicht der Erlösung bedürftig. Aber das spricht ja nun doch gerade nicht gegen sie und schon gar nicht spricht es für den Menschen, im Gegenteil! Da das Jesus hörte, sprach er zu ihnen: Nicht die Starken bedürfen des Arztes, sondern die Kranken. Ich bin nicht gekommen, Gerechte zu rufen, sondern Sünder (Mk 2, 17). Denn das menschliche Sündersein ist nun überhaupt kein Qualitätsmerkmal, auch wenn

Ja, Maschinen sind – zumindest nach derzeitigem theologischen Erkenntnisstand – nicht der Erlösung bedürftig. Aber das spricht ja nun doch gerade nicht gegen sie und schon gar nicht spricht es für den Menschen, im Gegenteil! Da das Jesus hörte, sprach er zu ihnen: Nicht die Starken bedürfen des Arztes, sondern die Kranken. Ich bin nicht gekommen, Gerechte zu rufen, sondern Sünder (Mk 2, 17). Denn das menschliche Sündersein ist nun überhaupt kein Qualitätsmerkmal, auch wenn  Gibt es also, so müsste man den Autor fragen, überhaupt irgendeine Situation, in der er über die Verstehensleistung der Maschine positiv urteilen würde? Sonst handelt es sich ja eher um einen billigen Taschenspielertrick oder sagen wir eine bloß rhetorische Frage, auf die die negative Antwort schon vorgegeben ist.

Gibt es also, so müsste man den Autor fragen, überhaupt irgendeine Situation, in der er über die Verstehensleistung der Maschine positiv urteilen würde? Sonst handelt es sich ja eher um einen billigen Taschenspielertrick oder sagen wir eine bloß rhetorische Frage, auf die die negative Antwort schon vorgegeben ist. Was ich nicht verstehe, ist der Triumphalismus, der dem Stolz darüber entspringt, dass die Maschine nicht dem Menschen gleich ist.

Was ich nicht verstehe, ist der Triumphalismus, der dem Stolz darüber entspringt, dass die Maschine nicht dem Menschen gleich ist. Zugegebenermaßen bin ich in dieser Frage befangen, weil mein Leben von Biosensoren, Algorithmen, Maschinen und Technologien abhängt. Deshalb beurteile ich diese vermutlich etwas positiver. Zumindest würde ich aus meiner irdischen Fehlbarkeit keinen Triumph machen wollen, es bekäme mir nicht.

Zugegebenermaßen bin ich in dieser Frage befangen, weil mein Leben von Biosensoren, Algorithmen, Maschinen und Technologien abhängt. Deshalb beurteile ich diese vermutlich etwas positiver. Zumindest würde ich aus meiner irdischen Fehlbarkeit keinen Triumph machen wollen, es bekäme mir nicht. Was aber, wenn die Trans-Humanisten oder die technologischen Post-Humanisten recht behalten und es gelingt, den menschlichen Geist in Maschinen zu überführen: werden diese dadurch doch erlösungsbedürftig? Oder brauchen sie das dann nicht mehr, weil sie ewig leben? Das zumindest ist ja der Traum aller Transhumanisten. Darüber muss man zumindest nachdenken. Man kann natürlich weiterhin "Proud to be flesh" sein („Stolz, aus Fleisch zu sein“), aber damit hat man die Herausforderung noch nicht bewältigt. Aus katholischer Perspektive hat Oliver Dürr entschieden an der Fleischlichkeit gegen den Transhumanismus festgehalten [Dürr, Oliver (2021): Homo Novus. Aschendorff (Studia Oecumenica Friburgensia, 108).] Er betont die „Vollendlichkeit im Zeitalter des Transhumanismus“. Ich bin da vorsichtiger.

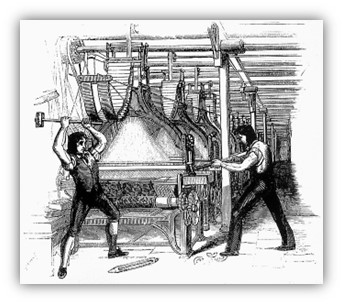

Was aber, wenn die Trans-Humanisten oder die technologischen Post-Humanisten recht behalten und es gelingt, den menschlichen Geist in Maschinen zu überführen: werden diese dadurch doch erlösungsbedürftig? Oder brauchen sie das dann nicht mehr, weil sie ewig leben? Das zumindest ist ja der Traum aller Transhumanisten. Darüber muss man zumindest nachdenken. Man kann natürlich weiterhin "Proud to be flesh" sein („Stolz, aus Fleisch zu sein“), aber damit hat man die Herausforderung noch nicht bewältigt. Aus katholischer Perspektive hat Oliver Dürr entschieden an der Fleischlichkeit gegen den Transhumanismus festgehalten [Dürr, Oliver (2021): Homo Novus. Aschendorff (Studia Oecumenica Friburgensia, 108).] Er betont die „Vollendlichkeit im Zeitalter des Transhumanismus“. Ich bin da vorsichtiger. Gerieren wir uns also nicht da als Maschinenstürmer, wo es nicht sinnvoll ist. Die Ätschi Bätschi Haltung gegenüber Computern. Androiden und Algorithmen-basierten Programmen steht uns nicht.

Gerieren wir uns also nicht da als Maschinenstürmer, wo es nicht sinnvoll ist. Die Ätschi Bätschi Haltung gegenüber Computern. Androiden und Algorithmen-basierten Programmen steht uns nicht.